ITCOW牛新网 12月27日消息,“深度求索”官方公众号于昨日(12月26日)宣布,其最新版本的 DeepSeek-V3 模型正式上线,并同步开源。这一全新的专家混合模型不仅在多个领域性能表现优异,还带来了更高的生成速度和社区适配支持。

DeepSeek-V3 技术亮点与性能提升

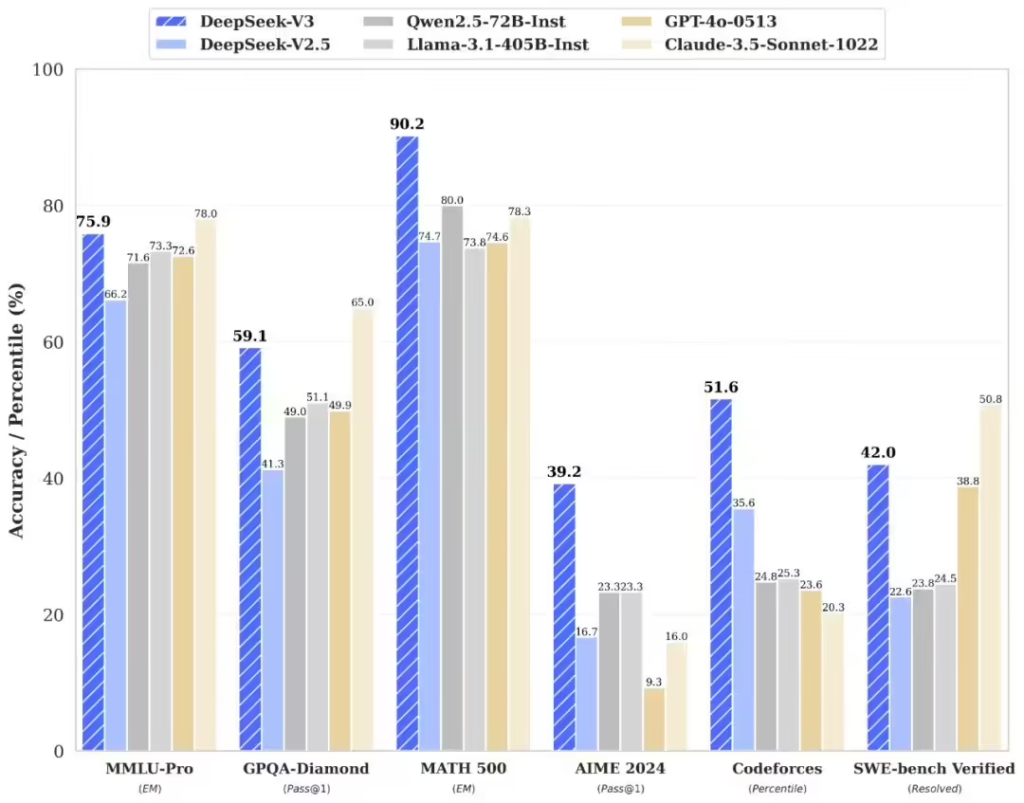

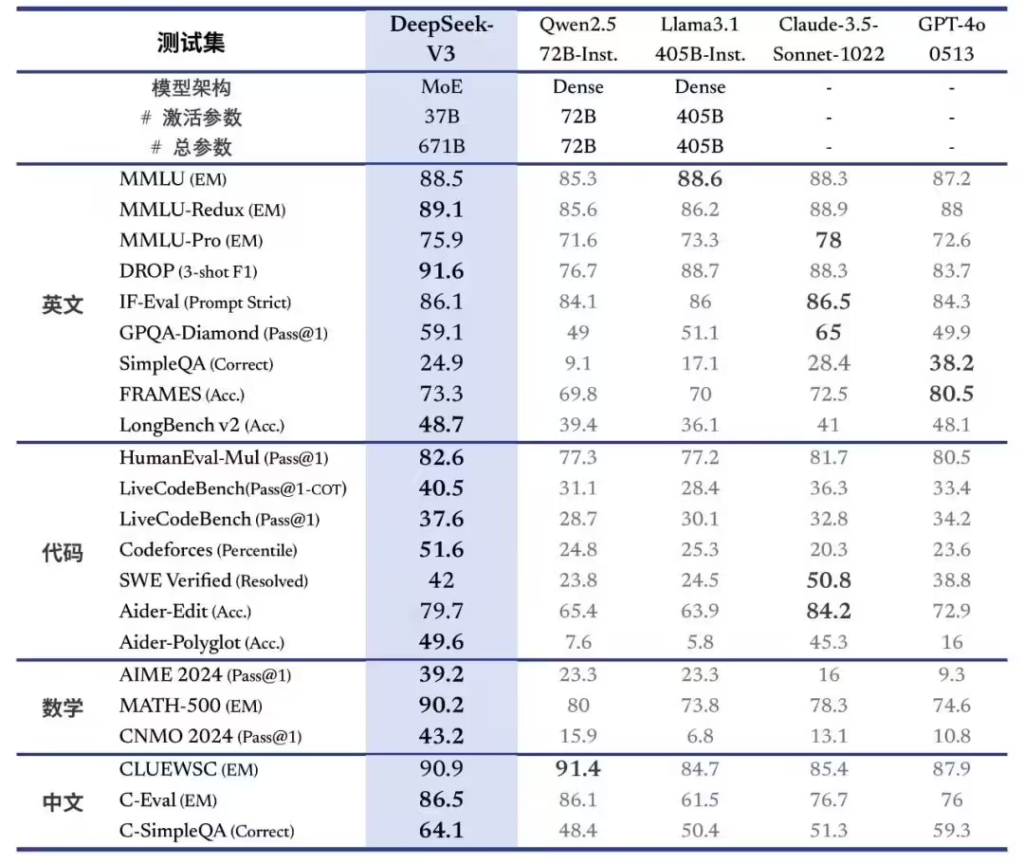

根据官方介绍,DeepSeek-V3 是一个具备 6710亿参数 的专家混合模型(MoE,专家网络结构),实际激活参数为 370 亿,并在 14.8万亿 tokens 上完成预训练。其性能在多个权威评测中表现出色,超越 Qwen2.5-72B 和 Llama-3.1-405B 等开源模型,与 GPT-4o 和 Claude-3.5-Sonnet 等闭源顶尖模型相媲美。

模型的主要技术突破包括:

- 全面提升知识能力:在知识问答、长文本理解、代码生成、数学计算等领域均有显著改进,特别是在算法代码和数学问题上的生成能力表现尤为突出。

- 更快的生成速度:模型生成速率达到 60 TPS,相较于 V2.5 提升了 3 倍,为用户带来了更高效的交互体验。

- 原生开源支持:官方提供了原生 FP8 权重 和 BF16 转换脚本,便于开发者社区快速适配和部署。此外,SGLang、LMDeploy、TensorRT-LLM 和 MindIE 等工具已经率先支持 V3 模型的推理。

API 服务价格调整与限时优惠

DeepSeek 在上线 V3 模型的同时调整了 API 服务定价:

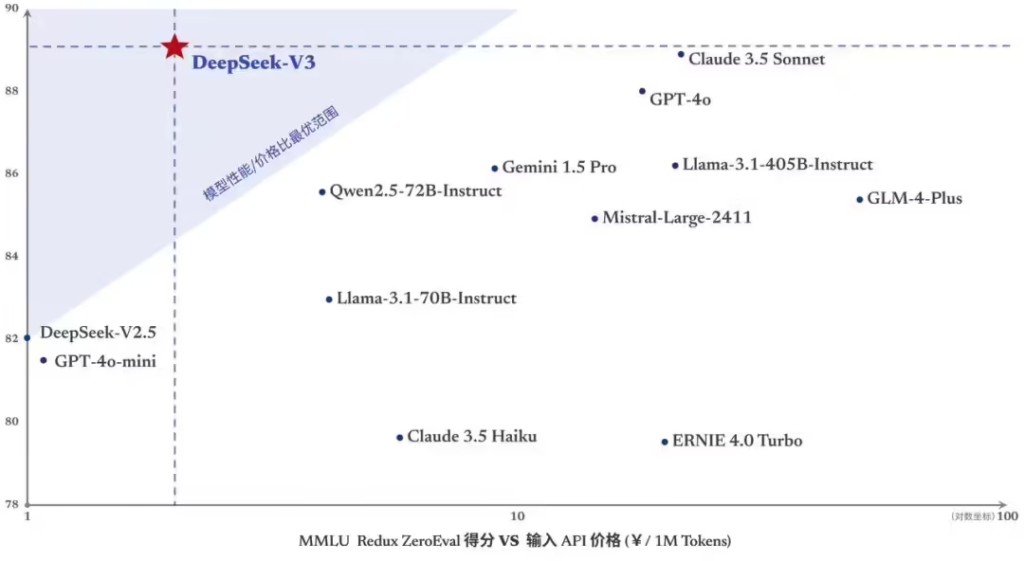

- 正式价格:每百万输入 tokens 收费 0.5 元(缓存命中)或 2 元(缓存未命中),每百万输出 tokens 收费 8 元。

为回馈用户,官方还推出了长达 45 天的优惠体验期,即日起至 2025年2月8日:

- 优惠价格:每百万输入 tokens 仅收 0.1 元(缓存命中)或 1 元(缓存未命中),每百万输出 tokens 收费仅 2 元。无论是注册已久的老用户,还是在此期间注册的新用户,都可享受该优惠政策。

DeepSeek-V3 的全面开源为开发者社区提供了更高的自由度与可扩展性。通过提供权重和部署脚本,结合现有支持的推理框架,开发者可以快速将 V3 模型应用于多种场景,例如智能问答、编程助手和数学解题工具等。