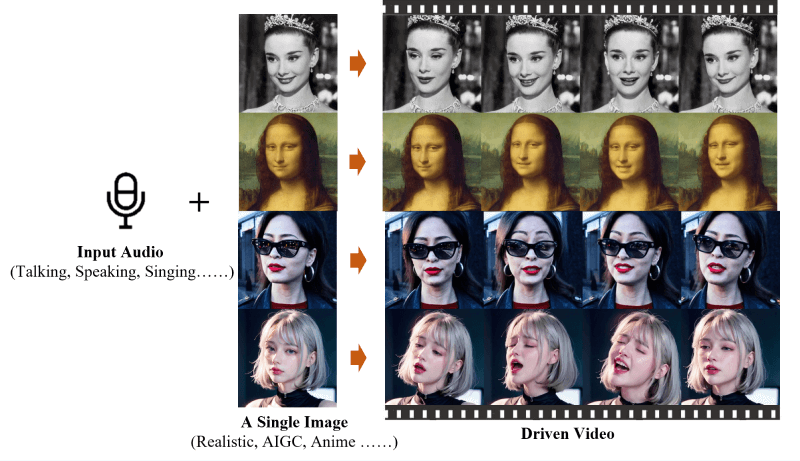

ITCOW牛新网 4月25日消息,阿里巴巴集团智能计算研究院近日推出了一款创新的AI技术产品——EMO(Emote Portrait Alive)框架。这一系统能够将单一的参考图像和语音音频转化为具有丰富表情和多样头部动作的视频,标志着人工智能在表情捕捉和视频生成领域的新突破。

EMO技术的核心在于其音频驱动的视频生成能力,它能够直接根据输入的音频生成视频,无需依赖预先录制的视频片段或3D面部模型。阿里云今日宣布,这一AI模型已正式在通义App上线,并对所有用户免费开放。用户只需选择一个模板,上传一张肖像照片,即可让EMO合成出一段生动的唱歌或表演视频。

据ITCOW牛新网了解,通义App首批推出了80多个EMO模板,覆盖了包括《上春山》、《野狼Disco》在内的热门歌曲,以及网络热梗“钵钵鸡”、“回手掏”等。不过,目前该功能尚未开放自定义音频的选项。

EMO的特点在于其高表现力和逼真度,能够精准捕捉并再现人类面部表情的微妙变化,以及与音频节奏同步的头部动作。此外,EMO的视频帧过渡自然流畅,避免了面部扭曲或帧间抖动的问题,确保了视频的高质量输出。通过FrameEncoding模块,EMO在视频生成过程中能够保持角色身份的一致性,确保角色外观与输入的参考图像相符。

EMO还采用了速度控制器和面部区域控制器等稳定控制机制,增强了视频生成的稳定性,避免了视频崩溃等问题。此外,EMO能够根据输入音频的长度灵活生成任意时长的视频,为用户提供了广阔的创作空间。其训练数据集覆盖了多种语言和风格,包括中文、英文,以及现实主义、动漫和3D风格,使得EMO能够适应多元的文化和艺术需求。