ITCOW牛新网 4月27日消息,阿里巴巴集团近日宣布开源其最新的人工智能语言模型——Qwen1.5-110B。该模型不仅在基础能力评估中与业界领先的Meta-Llama3-70B模型不相上下,更在Chat评估中展现出卓越的性能,特别是在MT-Bench和AlpacaEval 2.0的测试中。

Qwen1.5-110B模型采用了先进的Transformer解码器架构,并融入了分组查询注意力(Group Query Attention)技术,这使得模型在处理推理任务时更为高效。值得注意的是,该模型支持长达32K tokens的上下文长度,并且具备多语言能力,能够覆盖英语、中文、法语、西班牙语、德语、俄语、日语、韩语、越南语、阿拉伯语等多种语言,这无疑为多语言环境下的AI应用提供了强大的支持。

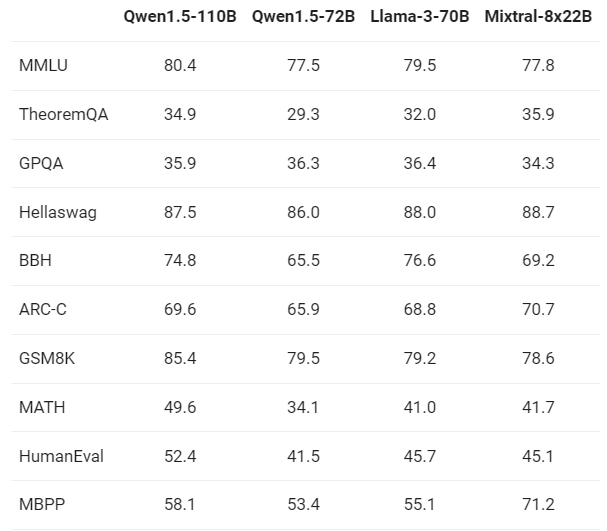

据ITCOW牛新网了解,阿里巴巴的Qwen1.5-110B模型在与Meta-Llama3-70B和Mixtral-8x22B等最新技术成果的对比中,展现了其在基础能力上的强劲实力。尽管阿里巴巴并未对预训练方法进行根本性的改变,但通过扩大模型规模,Qwen1.5-110B在性能上实现了显著的提升,这一点在与72B模型的比较中尤为明显。

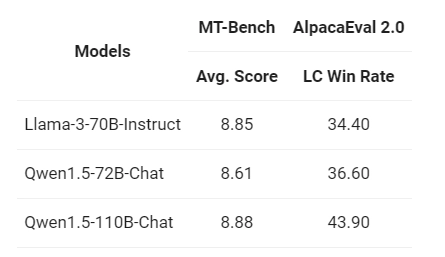

在Chat评估方面,Qwen1.5-110B在MT-Bench和AlpacaEval 2.0的测试中,相较于之前的72B模型,表现出了显著的改进。这一结果进一步证实了,即便是在后训练方法未有大幅调整的情况下,更大规模的基础语言模型也能带来性能上的飞跃,尤其是在Chat模型的构建上。

阿里巴巴方面还强调,Qwen1.5-110B不仅是Qwen1.5系列中规模最大的模型,也是该系列首个突破千亿参数大关的模型。它不仅在性能上与最新的SOTA模型Llama-3-70B相媲美,而且在某些方面甚至超越了72B模型。