ITCOW牛新网 6月7日消息,通义千问(Qwen)系列AI模型今日迎来升级,从Qwen1.5版本跃升至Qwen2,并已在Hugging Face和ModelScope平台上同步开源。

Qwen2.0版本在多个方面实现了显著的改进和扩展。该系列模型现在包含五个不同尺寸的预训练和指令微调模型,包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B。这些模型不仅在参数量上有所不同,还在上下文长度支持上有所提升,特别是Qwen2-72B-Instruct模型,其上下文长度支持最高可达128K tokens。

| 模型 | Qwen2-0.5B | Qwen2-1.5B | Qwen2-7B | Qwen2-57B-A14B | Qwen2-72B |

|---|---|---|---|---|---|

| 参数量 | 0.49B | 1.54B | 7.07B | 57.41B | 72.71B |

| 非 Embedding 参数量 | 0.35B | 1.31B | 5.98B | 56.32B | 70.21B |

| GQA | True | True | True | True | True |

| Tie Embedding | True | True | False | False | False |

| 上下文长度 | 32K | 32K | 128K | 64K | 128K |

据ITCOW牛新网了解,Qwen2系列在多语言支持上也取得了突破,除了中文和英语外,训练数据中还增加了27种语言的高质量数据。这使得Qwen2在多语言处理能力上得到了显著增强。

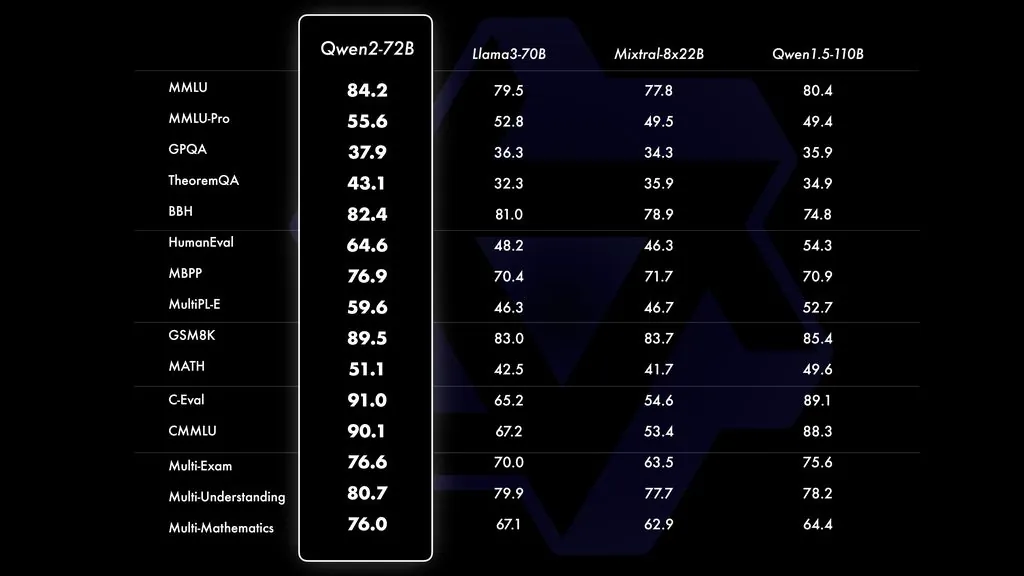

在性能评测方面,Qwen2-72B在多个评测基准上展现出了领先的表现。与当前最优的开源模型相比,Qwen2-72B在自然语言理解、知识、代码、数学以及多语言等多项能力上均有显著超越。特别是在MMLU、Pyne、GPQA等评测项目中,Qwen2-72B的得分均高于Llama-3-70B和Qwen1.5-110B。

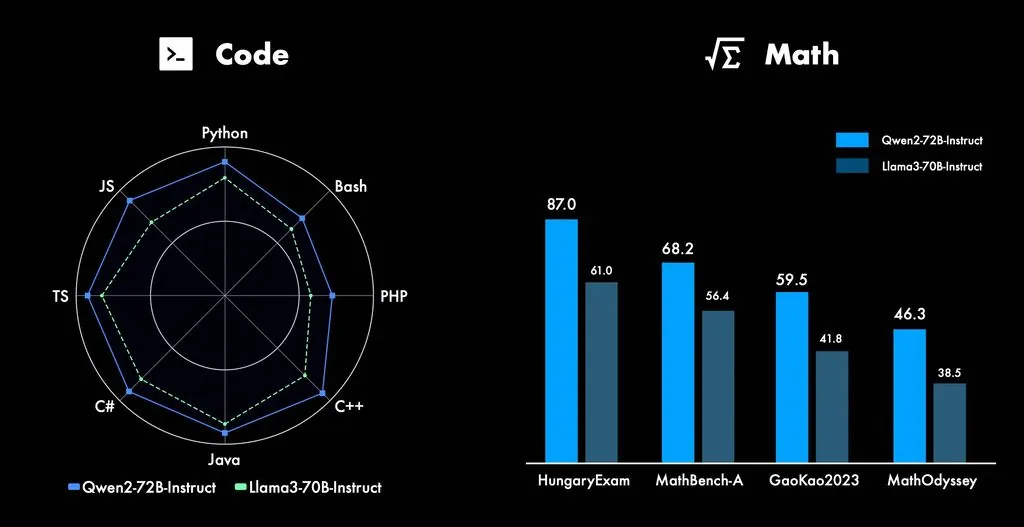

此外,Qwen2系列在代码和数学能力上也实现了显著提升。例如,在LiveCodeBench、GSM8k、MATH等评测项目中,Qwen2-72B的得分均高于其他模型,显示出其在这些领域的强大实力。