ITCOW牛新网 7月2日消息,月之暗面科技有限公司昨日宣布,其Kimi开放平台的上下文缓存(Context Caching)功能正式开启公测。这项技术在保持API价格不变的情况下,有望大幅降低开发者在使用长文本旗舰大模型时的成本,最高可达90%,同时显著提升模型的响应速度。

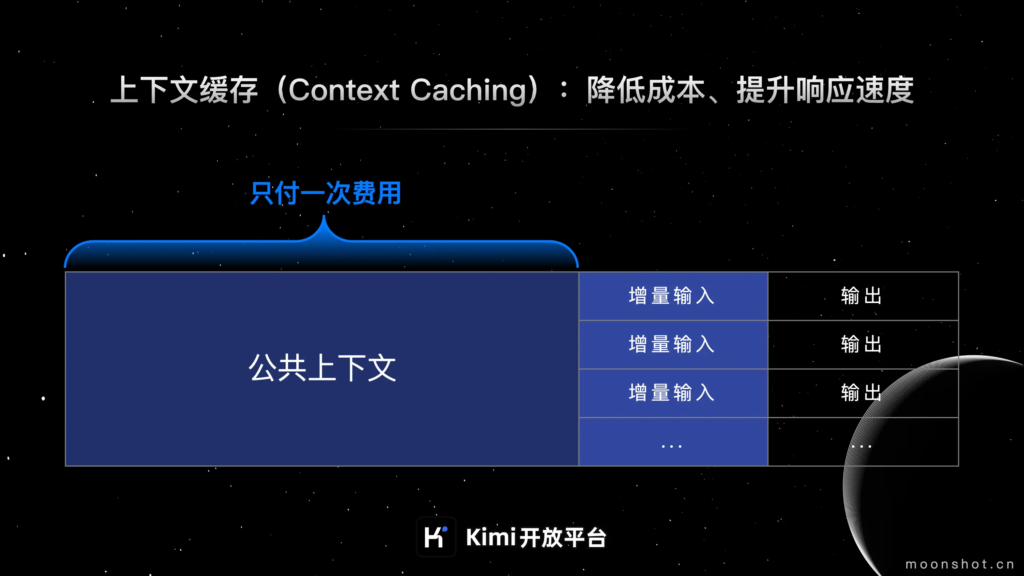

据月之暗面官方介绍,上下文缓存是一种先进的数据管理技术,它允许系统预先存储那些会被频繁请求的大量数据或信息。当用户请求相同的信息时,系统可以直接从缓存中提供,而无需再次进行计算或从原始数据源中检索,从而大大提高了效率。

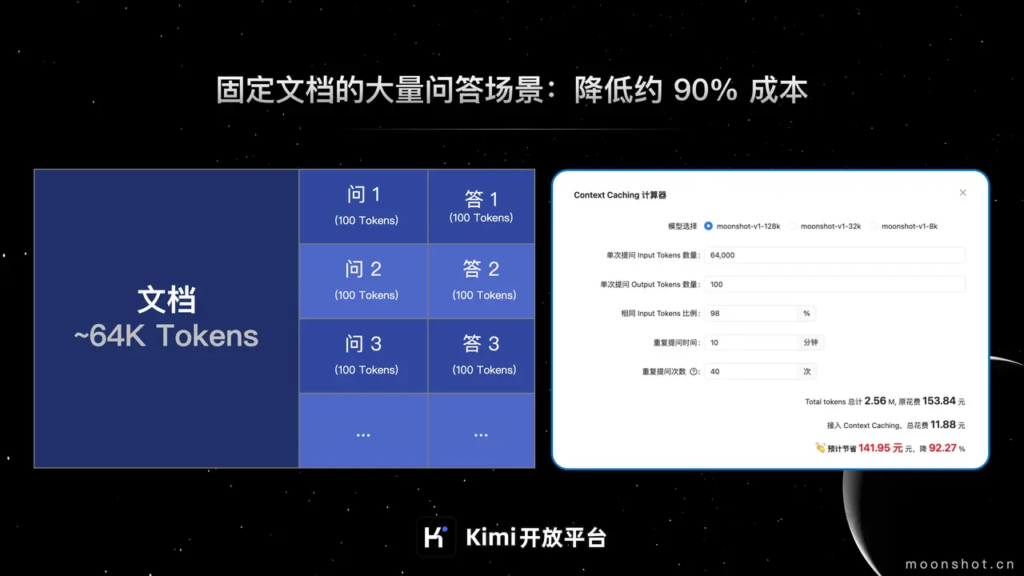

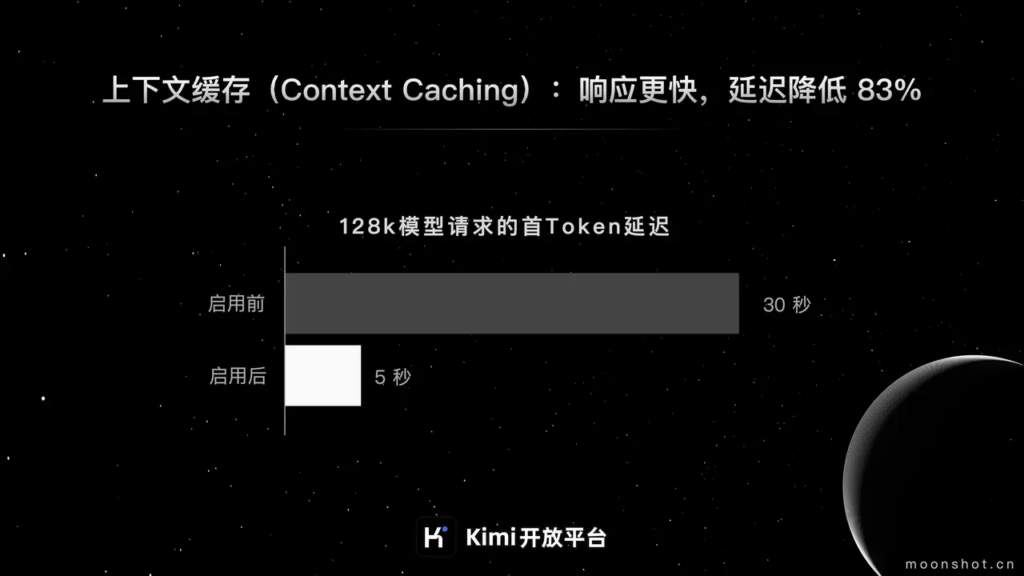

上下文缓存技术特别适用于那些需要频繁请求和重复引用大量初始上下文的场景。它不仅可以显著降低长文本模型的使用费用,还能提升处理效率。官方数据显示,费用最高可降低90%,首Token延迟降低83%。适用的业务场景包括:

- 提供大量预设内容的QA Bot,例如Kimi API小助手。

- 针对固定文档集合的频繁查询,如上市公司信息披露问答工具。

- 对静态代码库或知识库的周期性分析,例如各类Copilot Agent。

- 瞬时流量巨大的爆款AI应用,如哄哄模拟器、LLM Riddles。

- 交互规则复杂的Agent类应用等。

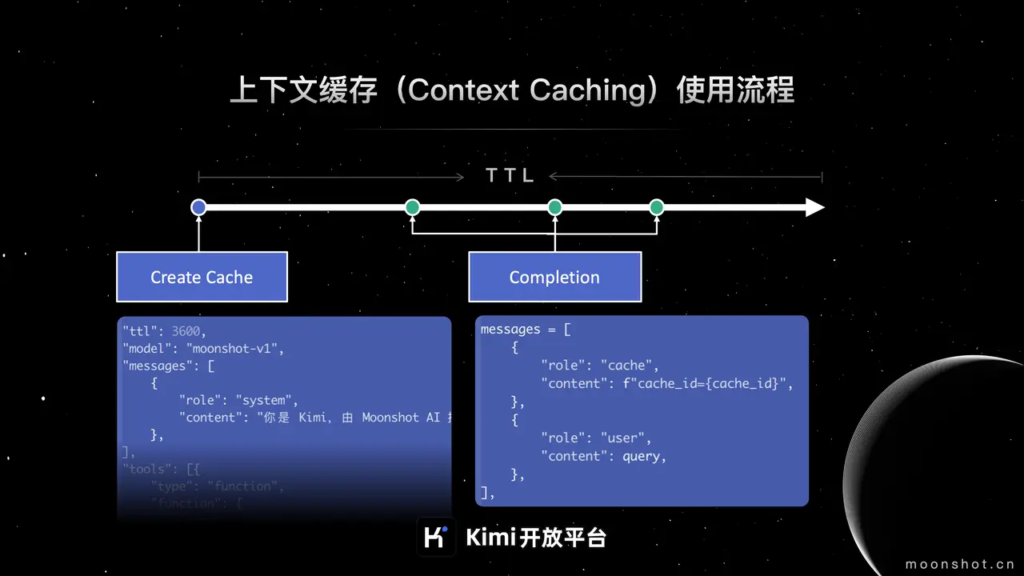

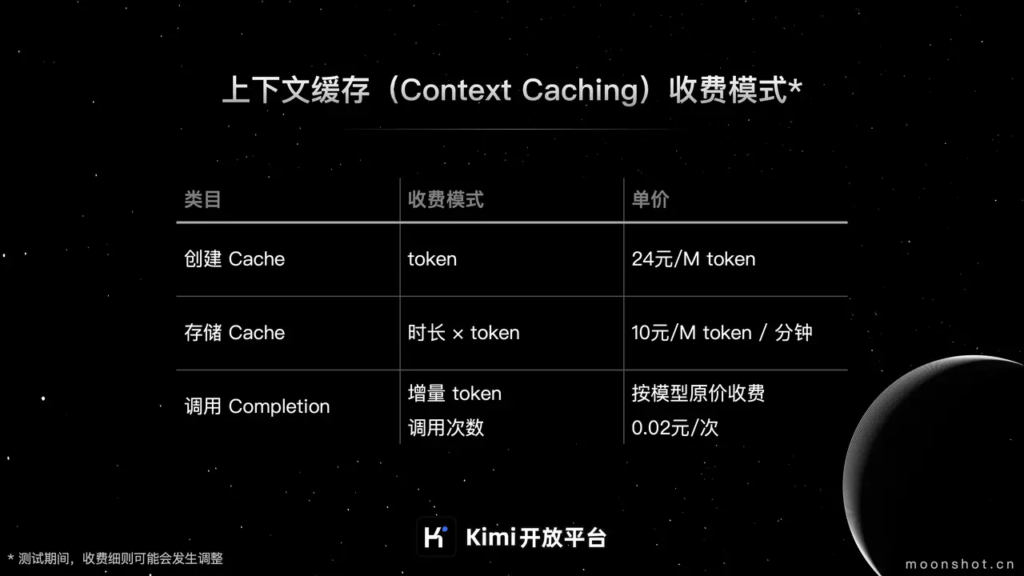

月之暗面Kimi开放平台上下文缓存的收费模式主要包括以下三个部分:

- Cache创建费用:调用Cache创建接口,成功创建Cache后,按照Cache中Tokens的实际量计费,价格为24元/M token。

- Cache存储费用:Cache存活时间内,按分钟收取Cache存储费用,价格为10元/M token/分钟。

- Cache调用费用:Cache调用增量token的收费按模型原价收费;Cache调用次数收费,若chat message内容与存活中的Cache匹配成功,将按调用次数收取费用,价格为0.02元/次。

公测时间:功能上线后,将持续公测3个月,期间价格可能会有所调整。

公测资格:在公测期间,Context Caching功能将优先开放给Tier5等级用户,其他用户的开放时间将另行通知。

附月之暗面Kimi开放平台Context Caching正式公测官方公告原文:点击查看