ITCOW牛新网 11月19日消息,在 SC24 超算大会上,英伟达正式推出两款新型 AI 硬件:H200 NVL PCIe GPU和GB200 NVL4 超级芯片,分别针对低功耗部署和高性能单服务器解决方案,进一步巩固其在 AI 和高性能计算(HPC)领域的技术优势。

H200 NVL PCIe GPU:低功耗风冷方案

H200 NVL 是英伟达为空气冷却、低功耗环境设计的 PCIe AIC 形态 AI 计算卡,专注于解决约七成企业机架电力供应不足 20kW 的问题。这款 GPU采用双槽厚度设计,最高 TDP 功耗从 H200 SXM 的 700W 降至 600W,在功耗优化的同时,算力相较 SXM 模型有所降低。例如,在 INT8 Tensor Core 算力方面下降约 15.6%。

不过,其HBM 内存容量与带宽保持与 H200 SXM 一致,分别为 141GB 和 4.8TB/s。此外,H200 NVL 支持双路或四路 NVLink 桥接器,每 GPU 的互联带宽可达 900GB/s。这一配置使其在 AI 推理与 HPC 应用中仍能提供显著性能提升:

- 内存容量较 H100 NVL 提升 1.5 倍。

- 带宽提升 1.2 倍。

- AI 推理性能提升 1.7 倍。

- HPC 应用性能提升 30%。

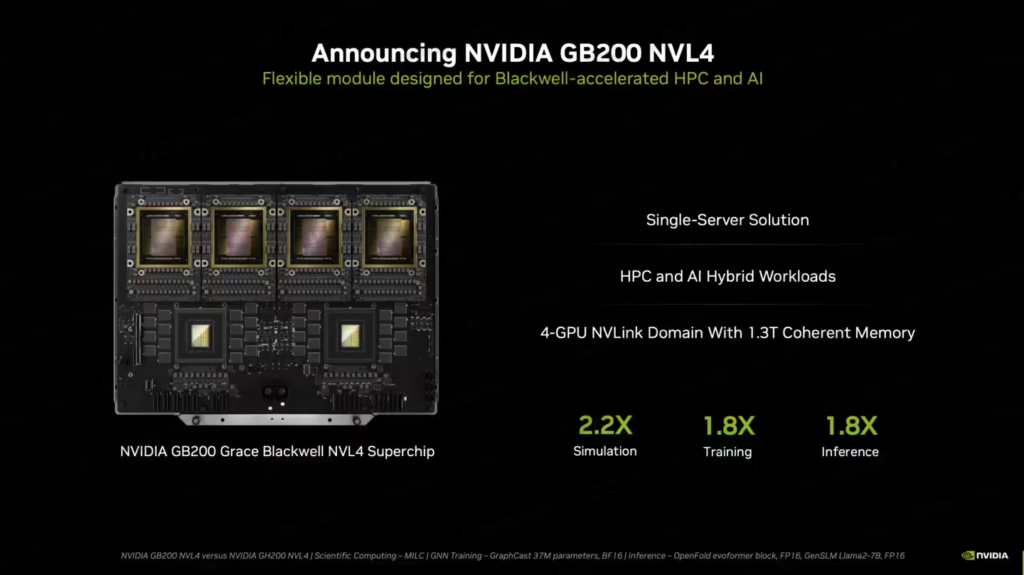

GB200 NVL4 超级芯片:单服务器的 AI 计算核心

GB200 NVL4 是英伟达为单服务器解决方案推出的新一代超级芯片,整合了2 个 Grace CPU 和 4 个 Blackwell GPU,具备 HBM 内存池容量 1.3TB,相当于两组 GB200 模块的配置。整体功耗为 5.4kW,适用于顶级计算需求。

与上一代包含 4 个 Grace CPU 和 4 个 Hopper GPU 的 GH200 NVL4 系统相比,GB200 NVL4 超级芯片的性能大幅提升:

- 模拟性能提升 2.2 倍。

- AI 训练性能提升 1.8 倍。

- AI 推理性能提升 1.8 倍。

英伟达表示,该芯片将在 2025 年下半年上市,为超算和AI训练提供更强劲的单服务器性能支持。

据ITCOW牛新网了解,H200 NVL 和 GB200 NVL4 分别聚焦不同市场需求。H200 NVL通过优化功耗和散热方案,为标准企业机架环境提供了经济高效的AI计算选项;GB200 NVL4则满足顶尖科研机构和企业对极限性能的追求。这两款硬件的推出,不仅巩固了英伟达在 AI 硬件领域的领先地位,还为多样化的AI和HPC应用场景带来了更多选择。