ITCOW牛新网 3月4日消息,微软今日宣布,通过 Azure AI Foundry 接入 DeepSeek-R1 7B 和 14B 蒸馏模型,为 Copilot+ PC 提供本地运行 7B 和 14B 模型的能力。

早在今年 1 月,微软就宣布计划将 DeepSeek-R1 模型的 NPU 优化版本直接带到搭载高通骁龙 X 处理器的 Copilot+ PC 上。如今,这一承诺终于兑现。微软表示,模型将首先在搭载高通骁龙 X 处理器的 Copilot+ PC 上线,随后扩展到英特尔酷睿 Ultra 200V 和 AMD 锐龙设备。

由于模型运行在 NPU(神经网络处理单元)上,因此可以显著减少对 PC 电池续航和散热性能的影响,同时持续提供 AI 计算能力。这意味着 CPU 和 GPU 可以解放出来,用于执行其他任务,从而提升整体系统效率。

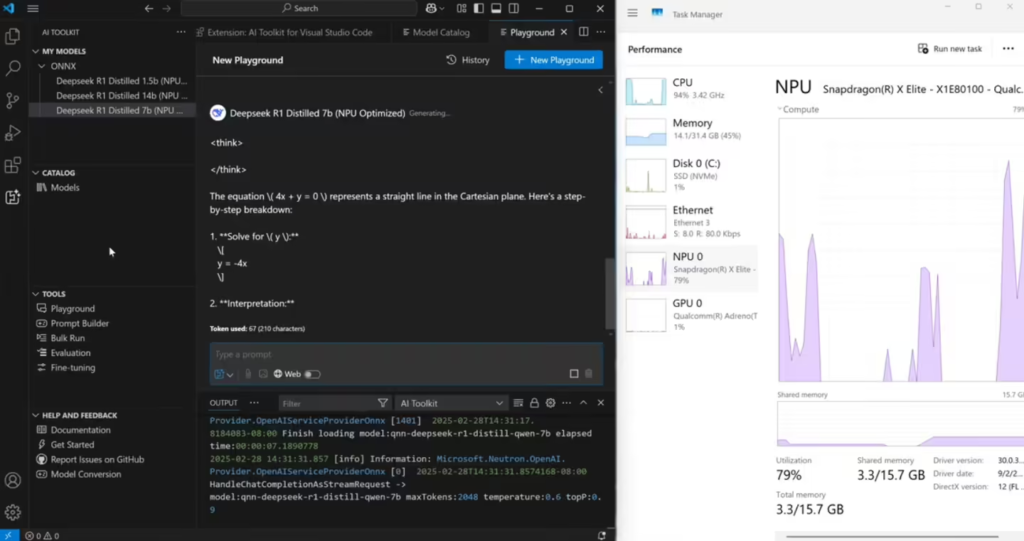

微软还透露,它使用了 Aqua 内部自动量化工具,将所有 DeepSeek 模型变体量化为 int4 权重。然而,目前模型的标记速度较低,14B 模型的标记速度仅为 8 tok / 秒,而 1.5B 模型的标记速度接近 40 tok / 秒。微软表示,正在进一步优化以提高速度。

开发者可以通过 AI Toolkit VS Code 扩展 在 Copilot+ PC 上下载和运行 DeepSeek 模型的 1.5B、7B 和 14B 版本。这一功能为开发者提供了更灵活的 AI 开发环境,支持他们在本地设备上高效运行和测试 AI 模型。