ITCOW牛新网 4月14日消息,字节跳动旗下豆包大模型团队今日公开了Seed-Thinking-v1.5技术细节,这款采用MoE架构的200B参数大模型将于4月17日通过火山引擎开放体验。该模型在保持顶尖性能表现的同时,单位推理成本较DeepSeek R1降低50%,实现效率与性能的完美平衡。

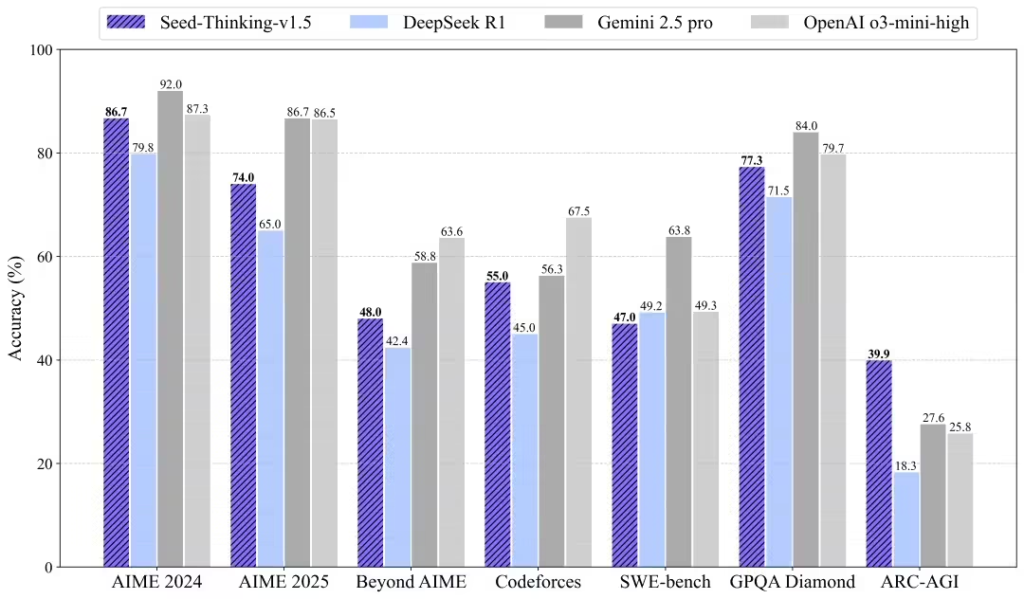

据ITCOW牛新网了解,Seed-Thinking-v1.5采用总参数200B、激活参数20B的MoE架构设计,在数学推理、编程竞赛和科学推理等专业领域表现亮眼:AIME 2024得分86.7追平OpenAI o3-mini-high,Codeforces pass@8达55.0%接近Gemini 2.5 Pro,GPQA得分77.3%同样达到业界第一梯队水平。通用任务表现更是超越DeepSeek R1达8%。

创新数据体系与训练方法

- 数据体系采用”双轨制”:可验证数据通过三重清洗保留10万道高难度题目,非可验证数据优化生成质量

- 训练方法创新:监督精调阶段构建40万高质量实例,强化学习阶段通过三重数据引擎动态调整

- 评测基准升级:构建超难数学数据集BeyondAIME,解决现有测试区分度不足问题

为支撑20B MoE模型的复杂训练需求,团队开发HybridFlow编程模型和流式推理系统(SRS),训练速度提升3倍。三层并行架构结合KARP算法,在万亿参数规模下仍保持95%的稳定性。