ITCOW牛新网11月14日消息,英伟达今日发布了新一代人工智能超级计算机芯片,这些芯片将在深度学习和大型语言模型(LLM)方面发挥关键作用,包括OpenAI的GPT-4等应用。这些新芯片将被用于数据中心和超级计算机,用于处理天气和气候预测、药物发现、量子计算等任务。

其中,关键的产品是基于英伟达的“Hopper”架构的HGX H200 GPU,它是H100 GPU的继任者,也是英伟达首款使用HBM3e内存的芯片。HBM3e内存速度更快,容量更大,特别适用于大型语言模型。英伟达表示,HGX H200搭载HBM3e内存,提供每秒4.8TB的速度和141GB的内存,容量几乎是A100的两倍,带宽增加了2.4倍。

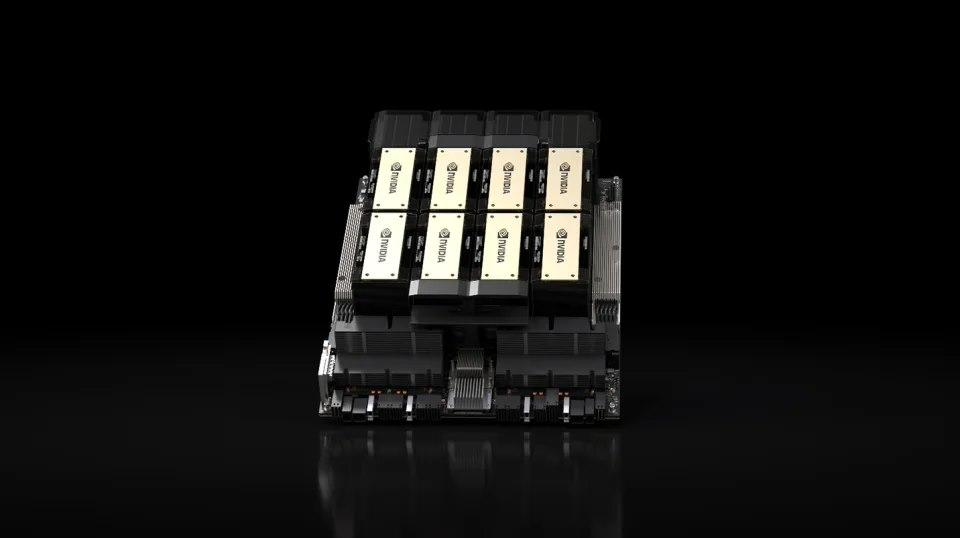

在人工智能方面,HGX H200在700亿参数的LLM应用Llama 2上的推理速度比H100快了一倍。HGX H200将提供4路和8路的配置,与H100系统兼容,适用于各种类型的数据中心,并将在Amazon Web Services、Google Cloud、Microsoft Azure和Oracle Cloud Infrastructure等云服务中部署,计划于2024年第二季度推出。

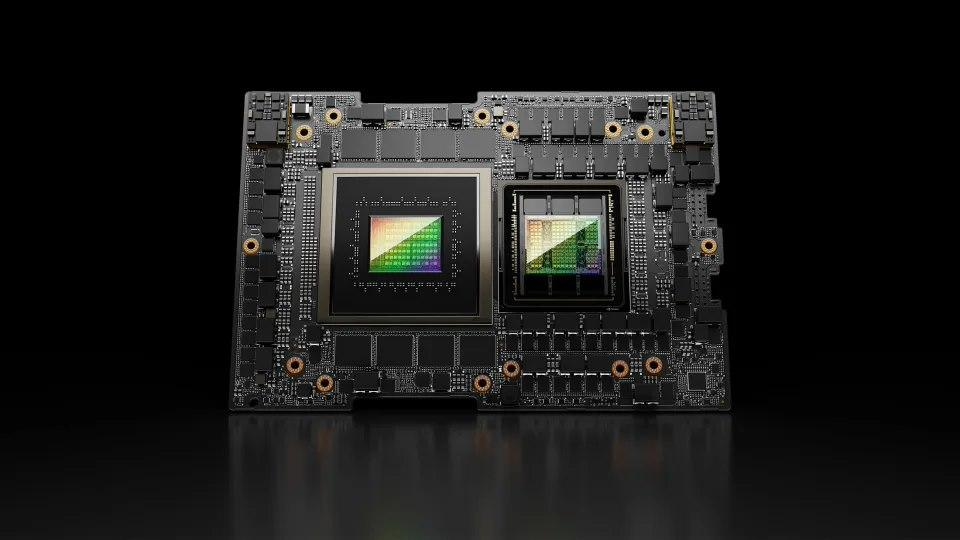

另一个重要产品是GH200 Grace Hopper“超级芯片”,它将HGX H200 GPU与基于Arm架构的英伟达Grace CPU结合起来,专为超级计算机设计,用于加速处理TB级别数据的复杂AI和HPC应用程序。GH200将应用于全球研究中心、系统制造商和云提供商的40多台AI超级计算机,包括戴尔、Eviden、惠普企业(HPE)、联想、QCT和Supermicro。其中,HPE的Cray EX2500超级计算机将使用四路GH200,可扩展到数万个Grace Hopper超级芯片节点。

英伟达表示,位于德国Jülich工厂的JUPITER超级计算机将成为“世界上最强大的AI系统”,预计将在2024年安装。JUPITER采用液冷架构,由近24000个英伟达GH200超级芯片组成,这些芯片通过英伟达Quantum-2 InfiniBand网络平台连接。JUPITER将用于气候和天气预测、药物发现、量子计算等多个领域,有望推动科学突破。

英伟达希望这些新GPU和超级芯片能够继续推动其在AI和数据中心领域的增长趋势,上个季度该领域实现了创纪录的103.2亿美元收入,总收入达到135.1亿美元,同比增长171%。